Guide complet des processus ETL (Extract, Transform, Load) : Techniques, exemples SQL et meilleures pratiques avec BigQuery

Le processus ETL, acronyme de « Extract, Transform, Load » (Extraction, Transformation, Chargement), est au cœur de l’entreposage de données. Il s’agit d’une série de procédures essentielles qui permettent de recueillir des données brutes provenant de différentes sources, de les transformer en informations utilisables et de les charger dans un entrepôt de données où elles peuvent être analysées. L’importance de l’ETL ne peut être sous-estimée, car il garantit que les données sont précises, cohérentes et prêtes à être utilisées pour des décisions stratégiques.

Le processus ETL est une composante essentielle de la gestion des données dans les entrepôts de données modernes. BigQuery, la solution d’entrepôt de données cloud de Google, offre des capacités puissantes et flexibles pour effectuer des opérations ETL à grande échelle. Ce guide vise à vous fournir une compréhension approfondie du processus ETL et à expliquer pourquoi BigQuery est une option idéale pour vos besoins en matière de traitement et d’analyse de données. Transformez votre curiosité en talent avec notre formations BigQuery pour apprendre le SQL, langage de requête indispensable pour récupérer et analyser les données.

- Guide complet des processus ETL (Extract, Transform, Load) : Techniques, exemples SQL et meilleures pratiques avec BigQuery

- Comprendre le processus ETL avec BigQuery ?

- Comparaison entre ETL et ELT avec BigQuery

- Que comprend la phase d'extraction du processus ETL ?

- Comment se déroule la phase de transformation avec BigQuery ?

- Comment s'effectue la phase de chargement dans BigQuery ?

- Quels sont les outils et technologies ETL disponibles ?

- En conclusion

- FAQ sur les processus ETL avec BigQuery

Comprendre le processus ETL avec BigQuery ?

Dans ce chapitre, nous allons explorer en profondeur le processus ETL (extraction, transformation et chargement) en utilisant BigQuery. Nous allons commencer par définir ce qu’est l’ETL, puis expliquer pourquoi BigQuery est un choix pertinent pour ces opérations. Enfin, nous offrirons une vue d’ensemble du processus ETL, en soulignant ses étapes essentielles et son importance dans la gestion des données.

Qu’est-ce que l’ETL ?

L’ETL est un acronyme qui signifie extraction, transformation et chargement. Il s’agit d’un processus utilisé pour intégrer des données provenant de diverses sources dans un entrepôt de données ou une base de données centralisée. Voici un aperçu de chaque étape :

- Extraction : cette étape consiste à collecter des données à partir de diverses sources, telles que des bases de données relationnelles, des fichiers plats, des API, ou des applications tierces. L’objectif est de rassembler les données nécessaires pour l’analyse et le reporting.

- Transformation : une fois les données extraites, elles sont transformées pour correspondre aux besoins de l’analyse. Cette étape peut inclure le nettoyage des données, la normalisation, l’agrégation, le calcul de nouvelles mesures, et la conversion de formats de données.

- Chargement : après transformation, les données sont chargées dans un entrepôt de données, où elles sont stockées de manière structurée et optimisée pour les requêtes et les analyses. Cette étape implique souvent des considérations de performance et de fiabilité pour assurer que les données sont accessibles rapidement et de manière fiable.

Pourquoi choisir BigQuery pour ETL ?

BigQuery est un entrepôt de données cloud entièrement géré par Google Cloud, conçu pour traiter de grandes quantités de données rapidement et efficacement. Il présente plusieurs avantages pour les processus ETL :

- Scalabilité : bigQuery peut gérer des pétaoctets de données, permettant aux entreprises de traiter de vastes ensembles de données sans souci de capacité.

- Performance : grâce à son architecture parallèle et à son optimisation pour les requêtes SQL, BigQuery permet d’exécuter des transformations de données complexes en un temps réduit.

- Simplicité : bigQuery élimine le besoin de gérer l’infrastructure, ce qui simplifie considérablement la mise en œuvre et la gestion des processus ETL.

- Intégration : bigQuery s’intègre bien avec d’autres services Google Cloud et des outils ETL populaires, facilitant l’importation, la transformation et l’exportation des données.

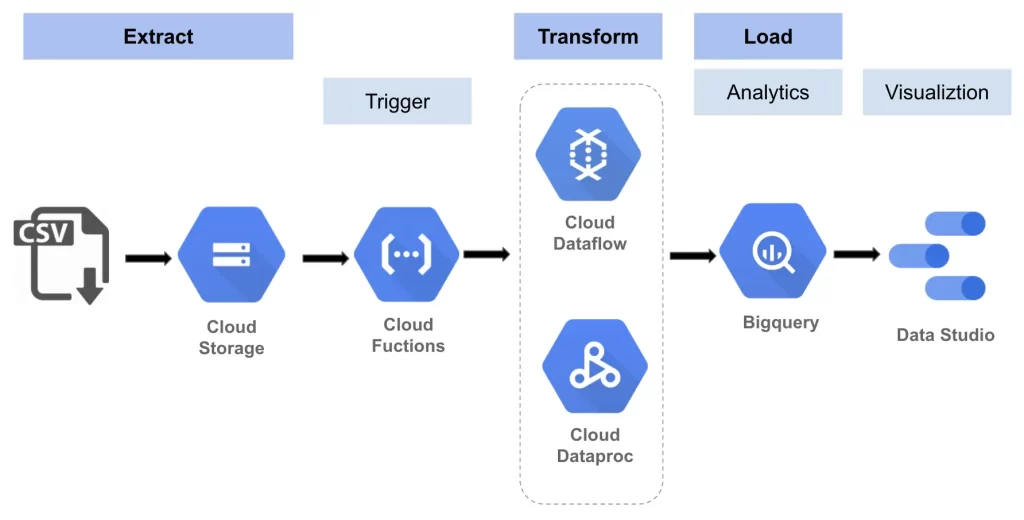

Quelle est la vue d’ensemble du processus ETL ?

Le processus ETL avec BigQuery se déroule en plusieurs étapes, chacune ayant ses propres spécificités et meilleures pratiques :

- Étape d’extraction : on commence par collecter les données à partir de diverses sources. Cela peut inclure des bases de données transactionnelles, des fichiers CSV, des flux de données en temps réel, etc. BigQuery peut se connecter à une multitude de sources de données via des connecteurs et des API.

- Étape de transformation : une fois les données extraites, elles sont transformées en utilisant SQL ou d’autres outils de traitement de données. Les transformations peuvent inclure des opérations de nettoyage, de regroupement, de calcul de nouvelles mesures, et de modification des formats de données pour qu’elles soient compatibles avec les besoins analytiques.

- Étape de chargement : enfin, les données transformées sont chargées dans BigQuery. Cette étape peut impliquer des opérations de partitionnement et de clustering pour optimiser les performances des requêtes. Une fois les données chargées, elles sont prêtes pour l’analyse et le reporting.

En somme, le processus ETL est une composante essentielle de la gestion des données, permettant de centraliser et de préparer les données pour l’analyse. BigQuery, avec ses capacités de traitement à grande échelle et son intégration facile, offre une solution puissante et flexible pour les processus ETL, facilitant ainsi l’exploitation efficace des données par les entreprises.

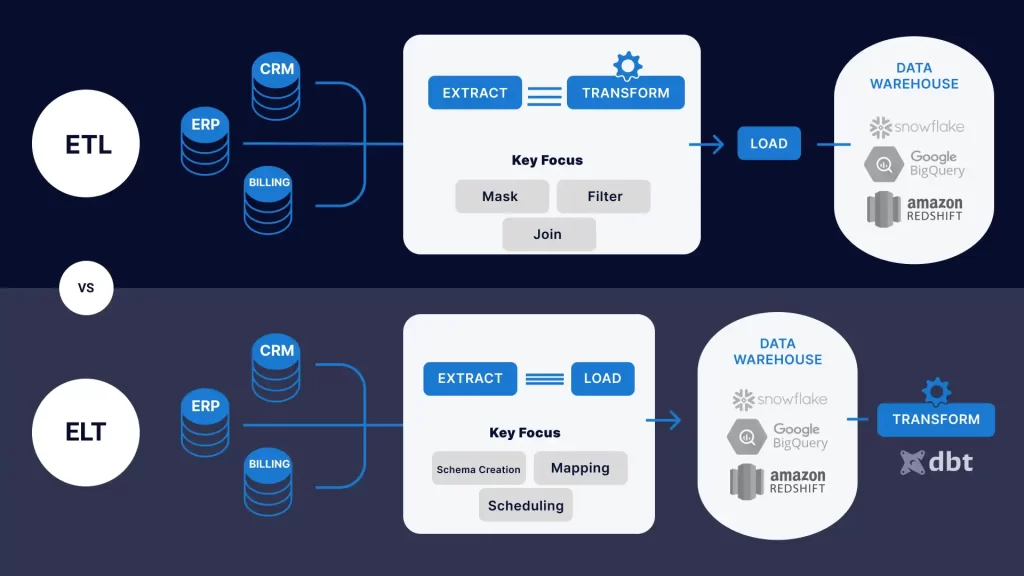

Comparaison entre ETL et ELT avec BigQuery

Comprendre les différences entre ETL (Extraction, Transformation, Chargement) et ELT (Extraction, Chargement, Transformation) est crucial pour choisir la méthode de traitement des données la plus adaptée à vos besoins. Ce tableau comparatif présente les aspects clés de chaque approche, leurs avantages, inconvénients et l’utilisation des capacités de BigQuery.

| Aspect | ETL | ELT |

|---|---|---|

| Étapes | Extraction, Transformation, Chargement | Extraction, Chargement, Transformation |

| Séquence | Les données sont transformées avant d’être chargées dans l’entrepôt de données | Les données sont chargées dans l’entrepôt de données avant d’être transformées |

| Transformation | Effectuée avant le chargement | Effectuée après le chargement |

| Avantages | – Qualité des données assurée avant le chargement <br> – Contrôle et flexibilité sur les données transformées | – Simplicité et rapidité de chargement <br> – Utilisation des capacités de traitement de l’entrepôt |

| Inconvénients | – Complexité et coût élevés <br> – Temps de latence avant que les données ne soient prêtes pour l’analyse | – Les données brutes nécessitent des contrôles de qualité supplémentaires <br> – Consommation de ressources de l’entrepôt |

| Utilisation des capacités de BigQuery | Intégration avec des outils ETL traditionnels pour transformer les données avant chargement | Chargement rapide des données brutes et transformation en utilisant SQL dans BigQuery |

Détails des différences entre ETL et ELT

Étapes

ETL : Dans cette méthode, les données sont extraites de diverses sources, transformées pour répondre aux besoins spécifiques avant d’être chargées dans l’entrepôt de données. Ce processus garantit que les données sont prêtes à être analysées immédiatement après leur chargement.

ELT : Ici, les données sont extraites de diverses sources et chargées directement dans l’entrepôt de données sans transformation préalable. Les transformations nécessaires sont ensuite effectuées à l’intérieur de l’entrepôt de données, en utilisant ses capacités de traitement.

Séquence

ETL : La transformation des données est une étape intermédiaire entre l’extraction et le chargement. Cela signifie que les données sont nettoyées, agrégées et mises en forme avant même d’atteindre l’entrepôt de données.

ELT : La transformation des données se produit après le chargement. Les données brutes sont d’abord stockées dans l’entrepôt, puis transformées en utilisant les outils et capacités de l’entrepôt.

Transformation

ETL : Les transformations sont réalisées avant le chargement, souvent à l’aide d’outils ETL spécialisés. Cela permet de s’assurer que seules des données nettoyées et préparées sont chargées dans l’entrepôt.

ELT : Les transformations sont effectuées après le chargement des données dans l’entrepôt. Cela permet d’utiliser la puissance de traitement de l’entrepôt pour effectuer des transformations complexes et traiter de grandes quantités de données plus efficacement.

🚀 Maîtrisez SQL pour exploiter pleinement vos données BigQuery !

Découvrez nos formations BigQuery adaptées à tous les niveaux, du débutant à l’expert. Apprenez à interroger, analyser et optimiser vos données avec SQL dans BigQuery, et exploitez toute la puissance du cloud pour des analyses avancées. Du niveau 1, où vous explorerez et visualiserez vos données avec BigQuery et Looker Studio, au niveau 2, qui vous permettra de maîtriser les requêtes SQL pour trier, filtrer et structurer efficacement vos données, jusqu’au niveau 3, dédié aux techniques avancées d’optimisation et d’automatisation. Que vous soyez analyste, data scientist ou développeur, ces formations vous permettront de gagner en autonomie et en efficacité dans le traitement de vos données.🔍📊

Avantages

ETL :

- Qualité des données assurée : La transformation préalable garantit que les données chargées sont prêtes pour l’analyse.

- Contrôle et flexibilité : Le processus de transformation en amont permet un contrôle étroit sur la qualité et la structure des données.

ELT :

- Simplicité et rapidité : En chargeant d’abord les données brutes, le processus est simplifié et accéléré.

- Utilisation des capacités de traitement de l’entrepôt : Permet de tirer parti des capacités de traitement massivement parallèle de BigQuery pour les transformations.

Inconvénients

ETL :

- Complexité et coût élevés : La transformation en amont peut nécessiter des ressources et des efforts considérables.

- Temps de latence : Les données ne sont pas immédiatement disponibles pour l’analyse après l’extraction.

ELT :

- Contrôles de qualité supplémentaires : Les données brutes nécessitent des vérifications et nettoyages post-chargement.

- Consommation de ressources : Les transformations peuvent monopoliser les ressources de l’entrepôt, affectant potentiellement les performances.

Utilisation des capacités de BigQuery

ETL : BigQuery s’intègre avec des outils ETL traditionnels comme Informatica, Talend, et SSIS, permettant de transformer les données avant de les charger.

ELT : BigQuery permet de charger rapidement de grandes quantités de données brutes. Les transformations sont ensuite réalisées en utilisant SQL et les capacités de traitement de BigQuery, comme les tables matérialisées et les fonctions analytiques avancées.

La décision entre ETL et ELT dépend des besoins spécifiques de votre organisation, tels que le volume de données, les compétences techniques de votre équipe, et les exigences de qualité des données. BigQuery offre des solutions flexibles et puissantes pour les deux approches, vous permettant d’optimiser vos processus de gestion des données selon vos besoins. En comprenant les avantages et inconvénients de chaque méthode, vous pouvez choisir la stratégie la plus adaptée pour maximiser l’efficacité et la performance de vos opérations de données.

Que comprend la phase d’extraction du processus ETL ?

La phase d’extraction est la première étape cruciale du processus ETL (Extraction, Transformation et Chargement). Cette phase consiste à récupérer des données de diverses sources pour les transférer dans un entrepôt de données. Dans ce chapitre, nous allons explorer en détail ce qu’est l’extraction, les sources de données courantes, les méthodes d’extraction avec BigQuery et fournir des exemples de code SQL pour illustrer le processus.

Qu’est-ce que l’extraction ?

L’extraction est le processus de récupération de données brutes de différentes sources, telles que des bases de données, des fichiers plats, des applications cloud, et bien plus encore. Cette étape est essentielle car elle permet de collecter toutes les informations nécessaires pour les phases ultérieures de transformation et de chargement. L’objectif principal est de s’assurer que toutes les données pertinentes sont disponibles et prêtes à être transformées et analysées.

L’extraction doit être effectuée de manière efficace pour minimiser l’impact sur les systèmes source et garantir que les données récupérées sont complètes et exactes. Il existe plusieurs techniques pour extraire les données, en fonction des caractéristiques des systèmes source et des besoins spécifiques du projet.

Quelles sont les sources de données courantes ?

Les sources de données peuvent varier considérablement en fonction de l’organisation et des systèmes en place. Voici quelques-unes des sources de données les plus courantes :

- Bases de données relationnelles : MySQL, PostgreSQL, SQL Server, Oracle.

- Fichiers plats : CSV, JSON, XML.

- Applications cloud : Salesforce, Google Analytics, HubSpot.

- Services web et API : RESTful APIs, SOAP APIs.

- Dépôts de données en temps réel : Kafka, Kinesis.

Chaque source de données a ses propres caractéristiques et défis en matière d’extraction. Par exemple, les bases de données relationnelles nécessitent souvent des connexions SQL pour extraire les données, tandis que les API peuvent nécessiter des appels HTTP et des mécanismes d’authentification spécifiques.

Quelles sont les méthodes d’extraction avec BigQuery ?

BigQuery, le service d’entrepôt de données de Google, offre plusieurs méthodes pour extraire des données de diverses sources. Voici quelques-unes des méthodes les plus courantes :

- BigQuery Data Transfer Service : Ce service permet de configurer des transferts de données planifiés à partir de sources externes comme Google Analytics, Google Ads, YouTube, et bien d’autres, directement dans BigQuery.

- Chargement de fichiers depuis Google Cloud Storage : Vous pouvez charger des fichiers CSV, JSON, Avro, Parquet, ou ORC stockés dans Google Cloud Storage directement dans BigQuery en utilisant des commandes SQL ou l’interface web de BigQuery.

- Federated Query : BigQuery permet de créer des requêtes fédérées pour interroger des données stockées dans d’autres services Google Cloud, tels que Google Cloud Storage ou Google Sheets, sans avoir à les déplacer d’abord dans BigQuery.

- APIs et outils tiers : Il existe de nombreuses API et outils tiers qui peuvent être utilisés pour extraire des données de sources variées et les charger dans BigQuery, comme Fivetran, Stitch, et Talend.

Quels sont les exemples de code SQL pour l’extraction ?

Pour illustrer la phase d’extraction, voici quelques exemples de code SQL utilisés avec BigQuery pour extraire des données de différentes sources :

Chargement de données depuis un fichier CSV dans Google Cloud Storage

LOAD DATA INTO my_dataset.my_table

FROM 'gs://my_bucket/my_file.csv'

WITH

FORMAT = 'CSV',

FIELD_DELIMITER = ',',

SKIP_HEADER = 1;

Explication :

Le SQL vous semble étrange ? Suivez notre formation BigQuery SQL pour apprendre les bases indispensable du SQL dans BigQuery.

- LOAD DATA INTO my_dataset.my_table : Cette commande indique que nous voulons charger des données dans la table

my_tablesituée dans le datasetmy_dataset. - FROM ‘gs://my_bucket/my_file.csv’ : Spécifie l’emplacement du fichier CSV dans Google Cloud Storage (GCS) avec l’URL

gs://my_bucket/my_file.csv. - WITH FORMAT = ‘CSV’ : Indique que le fichier est au format CSV.

- FIELD_DELIMITER = ‘,’ : Indique que le séparateur de champs dans le fichier CSV est une virgule.

- SKIP_HEADER = 1 : Indique que la première ligne du fichier CSV contient les en-têtes des colonnes et doit être ignorée lors du chargement des données.

Extraction de données depuis une table existante

CREATE TABLE my_dataset.my_new_table AS

SELECT *

FROM my_dataset.my_existing_table

WHERE condition_column = 'condition_value';

Explication :

- CREATE TABLE my_dataset.my_new_table AS : Crée une nouvelle table

my_new_tabledans le datasetmy_datasetet y insère les données issues de la requête suivante. - SELECT : Sélectionne toutes les colonnes de la table source.

- FROM my_dataset.my_existing_table : Spécifie la table source

my_existing_tablesituée dans le datasetmy_dataset. - WHERE condition_column = ‘condition_value’ : Filtre les lignes de la table source où la colonne

condition_columna la valeurcondition_value. Seules ces lignes seront insérées dans la nouvelle tablemy_new_table.

Utilisation de BigQuery Data Transfer Service pour extraire des données de Google Analytics

-- Ce code nécessite la configuration préalable du BigQuery Data Transfer Service

SELECT *

FROM `my_project.my_dataset.ga_sessions_*`

WHERE _TABLE_SUFFIX BETWEEN '20230101' AND '20230131';

Explication :

- SELECT : Sélectionne toutes les colonnes des tables concernées.

- FROM

my_project.my_dataset.ga_sessions_*: Indique que les données doivent être extraites de plusieurs tables dont les noms commencent parga_sessions_, situées dans le datasetmy_datasetdu projetmy_project. L’astérisque (*) est un joker utilisé pour représenter des tables partitionnées par date, typiquement créées par le service de transfert de données de Google Analytics. - WHERE _TABLE_SUFFIX BETWEEN ‘20230101’ AND ‘20230131’ : Filtre les tables pour n’inclure que celles correspondant aux dates comprises entre le 1er janvier 2023 et le 31 janvier 2023.

_TABLE_SUFFIXest une pseudo-colonne qui représente la partie du nom de la table qui suitga_sessions_, correspondant généralement à la date.

Ces exemples montrent comment différentes méthodes peuvent être utilisées pour extraire des données dans BigQuery. Chaque méthode a ses propres avantages et peut être choisie en fonction des besoins spécifiques du projet et des caractéristiques des sources de données.

En conclusion, la phase d’extraction est essentielle pour garantir que toutes les données pertinentes sont collectées de manière efficace et prête à être transformée et chargée dans l’entrepôt de données. En utilisant BigQuery, les utilisateurs disposent de plusieurs outils et méthodes pour simplifier et optimiser ce processus.

Comment se déroule la phase de transformation avec BigQuery ?

La phase de transformation est cruciale dans le processus ETL (Extraction, Transformation et Chargement). Elle permet de convertir les données brutes extraites en un format plus approprié pour l’analyse et la prise de décision. BigQuery, avec ses capacités puissantes de traitement de données massives et son langage SQL, offre des outils et des techniques efficaces pour accomplir cette étape. Ce chapitre explore en profondeur ce qu’est la transformation, les techniques courantes, comment utiliser BigQuery pour transformer les données et présente des exemples concrets de code SQL pour illustrer ces concepts.

Qu’est-ce que la transformation ?

La transformation des données consiste à modifier, nettoyer et enrichir les données extraites pour les rendre utiles et exploitables. Ce processus peut inclure des opérations telles que :

- La normalisation et la dénormalisation des données

- Le filtrage des données non pertinentes

- La conversion des formats de données

- L’agrégation de données

- L’application de règles métier pour créer de nouvelles données dérivées

La transformation vise à assurer que les données sont cohérentes, précises et prêtes à être chargées dans l’entrepôt de données pour des analyses ultérieures.

Quelles sont les techniques de transformation courantes ?

Il existe plusieurs techniques de transformation des données, parmi les plus courantes :

Nettoyage des données : Ce processus consiste à corriger ou supprimer les données incorrectes, corrompues, mal formatées ou incomplètes au sein de l’ensemble de données. Par exemple, la suppression des doublons, la correction des valeurs erronées et le remplissage des valeurs manquantes.

Normalisation et dénormalisation : La normalisation consiste à structurer les données pour minimiser la redondance et améliorer l’intégrité des données. La dénormalisation, à l’inverse, peut être utilisée pour améliorer les performances des requêtes en regroupant les données.

Conversion de type de données : Cette technique est utilisée pour convertir les types de données d’un format à un autre, par exemple, transformer des chaînes de caractères en dates ou des nombres en chaînes.

Agrégation de données : Il s’agit de combiner plusieurs lignes de données en une seule en utilisant des fonctions d’agrégation comme SUM, COUNT, AVG, etc.

Enrichissement des données : Ce processus consiste à ajouter des informations supplémentaires aux données existantes, par exemple, en fusionnant des jeux de données ou en appliquant des règles métier pour créer de nouvelles variables.

Comment utiliser BigQuery pour la transformation ?

BigQuery est une plateforme de data warehousing gérée par Google qui permet de traiter des volumes massifs de données rapidement et efficacement. Pour la transformation des données, BigQuery utilise le langage SQL. Voici quelques fonctionnalités et techniques spécifiques à BigQuery qui facilitent ce processus :

Requêtes SQL avancées : BigQuery prend en charge des requêtes SQL complexes qui permettent de transformer les données de manière efficace. Vous pouvez utiliser des sous-requêtes, des fonctions analytiques, des jointures et des agrégations pour manipuler les données selon vos besoins.

Fonctions analytiques : BigQuery propose des fonctions analytiques telles que RANK(), DENSE_RANK(), ROW_NUMBER(), et bien d’autres, qui sont utiles pour des transformations avancées.

UDFs (User-Defined Functions) : BigQuery permet de créer des fonctions définies par l’utilisateur en JavaScript ou SQL, ce qui offre une flexibilité supplémentaire pour des transformations spécifiques.

CTEs (Common Table Expressions) : Les CTEs facilitent l’écriture de requêtes SQL complexes en permettant de définir des tables temporaires pour organiser les transformations.

Quels sont les exemples de code SQL pour la transformation ?

Pour illustrer les capacités de transformation de BigQuery, voici quelques exemples de code SQL couramment utilisés :

Nettoyage des données :

-- Suppression des doublons

SELECT DISTINCT *

FROM dataset.table;

-- Correction des valeurs incorrectes

UPDATE dataset.table

SET column = 'valeur_corrigée'

WHERE column = 'valeur_incorrecte';

Explication :

SELECT DISTINCT *: Sélectionne toutes les colonnes de la tabletableen éliminant les doublons.FROM dataset.table: Spécifie la table sourcetablesituée dans le datasetdataset.UPDATE dataset.table: Met à jour les valeurs dans la tabletabledu datasetdataset.SET column = 'valeur_corrigée': Définit une nouvelle valeur pour la colonne spécifiée.WHERE column = 'valeur_incorrecte': Applique la mise à jour uniquement aux lignes où la colonne a la valeur incorrecte spécifiée.

Normalisation des données :

-- Normalisation en divisant une table en plusieurs tables plus petites

CREATE TABLE dataset.normalized_table AS

SELECT id, colonne1, colonne2

FROM dataset.original_table;

CREATE TABLE dataset.related_table AS

SELECT id, colonne3, colonne4

FROM dataset.original_table;

Explication :

CREATE TABLE dataset.normalized_table AS: Crée une nouvelle tablenormalized_tabledans le datasetdatasetet y insère les données issues de la requête suivante.SELECT id, colonne1, colonne2 FROM dataset.original_table: Sélectionne les colonnesid,colonne1etcolonne2de la tableoriginal_tabledans le datasetdataset.CREATE TABLE dataset.related_table AS: Crée une autre tablerelated_tabledans le datasetdatasetavec d’autres colonnes.SELECT id, colonne3, colonne4 FROM dataset.original_table: Sélectionne les colonnesid,colonne3etcolonne4de la tableoriginal_table.

Agrégation des données :

-- Agrégation des ventes mensuelles

SELECT EXTRACT(YEAR FROM date) AS year, EXTRACT(MONTH FROM date) AS month, SUM(ventes) AS total_ventes

FROM dataset.sales

GROUP BY year, month;

Explication :

SELECT EXTRACT(YEAR FROM date) AS year, EXTRACT(MONTH FROM date) AS month: Extrait l’année et le mois de la colonnedateet les nomme respectivementyearetmonth.SUM(ventes) AS total_ventes: Calcule la somme des ventes et la nommetotal_ventes.FROM dataset.sales: Spécifie la table sourcesalesdans le datasetdataset.GROUP BY year, month: Regroupe les résultats par année et mois.

Conversion de type de données :

-- Conversion de chaînes de caractères en dates

SELECT CAST(date_string AS DATE)

FROM dataset.table;

-- Conversion de nombres en chaînes

SELECT CAST(number AS STRING)

FROM dataset.table;

Explication :

SELECT CAST(date_string AS DATE): Convertit la colonnedate_stringen typeDATE.FROM dataset.table: Spécifie la table sourcetabledans le datasetdataset.SELECT CAST(number AS STRING): Convertit la colonnenumberen typeSTRING.

Utilisation des CTEs :

-- Utilisation de CTE pour organiser une transformation complexe

WITH sales_summary AS (

SELECT salesperson_id, SUM(ventes) AS total_ventes

FROM dataset.sales

GROUP BY salesperson_id

)

SELECT s.salesperson_id, s.total_ventes, e.nom, e.prenom

FROM sales_summary s

JOIN dataset.employees e ON s.salesperson_id = e.id;

Explication :

WITH sales_summary AS: Déclare une CTE nomméesales_summary.SELECT salesperson_id, SUM(ventes) AS total_ventes FROM dataset.sales GROUP BY salesperson_id: Calcule la somme des ventes par vendeur et nomme cette sommetotal_ventes.SELECT s.salesperson_id, s.total_ventes, e.nom, e.prenom FROM sales_summary s JOIN dataset.employees e ON s.salesperson_id = e.id: Sélectionne l’ID du vendeur, le total des ventes, le nom et le prénom des employés en joignant la CTEsales_summaryavec la tableemployeessur l’ID du vendeur.

Ces exemples montrent comment BigQuery peut être utilisé pour effectuer des transformations de données variées et complexes. En combinant ces techniques avec des pratiques optimales, vous pouvez transformer efficacement vos données brutes en informations exploitables.

Comment s’effectue la phase de chargement dans BigQuery ?

La phase de chargement est la dernière étape du processus ETL (Extraction, Transformation et Chargement). Une fois que les données ont été extraites et transformées, elles doivent être chargées dans un entrepôt de données pour être accessibles et analysables. BigQuery, en tant que solution de data warehousing gérée par Google, offre des outils puissants pour charger des volumes massifs de données de manière rapide et efficace. Ce chapitre détaille ce qu’est le chargement, les stratégies de chargement des données, comment utiliser BigQuery pour le chargement, et présente des exemples concrets de code SQL pour illustrer ces concepts.

Qu’est-ce que le chargement ?

Le chargement des données consiste à importer les données transformées dans l’entrepôt de données. Cette étape est cruciale car elle assure que les données sont disponibles pour les analyses ultérieures. Le processus de chargement doit être réalisé de manière à minimiser l’interruption des services et à garantir l’intégrité des données. Le chargement peut inclure des opérations telles que :

- L’insertion des données nouvelles ou mises à jour

- La gestion des conflits et des duplications de données

- L’optimisation des performances de chargement

La réussite du chargement des données garantit que les utilisateurs finaux peuvent accéder à des informations précises et à jour pour leurs besoins analytiques.

quelles sont les stratégies de chargement des données ?

Il existe plusieurs stratégies pour charger les données dans un entrepôt de données, et le choix de la stratégie dépend de divers facteurs tels que le volume des données, la fréquence des mises à jour, et les besoins de performance. Voici quelques stratégies courantes :

Chargement complet : Cette méthode consiste à supprimer toutes les données existantes dans une table et à recharger entièrement la table avec les nouvelles données. Bien que simple, cette approche peut être inefficace pour les grandes tables car elle nécessite beaucoup de temps et de ressources.

Chargement incrémentiel : Plutôt que de recharger toutes les données, cette méthode ne charge que les données nouvelles ou modifiées depuis le dernier chargement. Cette stratégie est plus efficace pour les grands ensembles de données car elle réduit le volume de données à charger.

Chargement par lots : Les données sont collectées et chargées par lots à intervalles réguliers. Cette méthode est utile pour gérer les données volumineuses et réduire l’impact sur les performances du système.

Chargement en temps réel : Les données sont chargées en continu au fur et à mesure qu’elles sont générées. Cette méthode est cruciale pour les applications nécessitant des données à jour en temps réel, mais elle peut être complexe à mettre en œuvre.

Comment utiliser BigQuery pour le chargement ?

BigQuery offre plusieurs méthodes pour charger des données, chacune adaptée à des besoins spécifiques. Voici quelques-unes des principales méthodes :

Chargement depuis des fichiers : BigQuery permet de charger des données depuis des fichiers stockés dans Google Cloud Storage. Ces fichiers peuvent être au format CSV, JSON, Avro, Parquet ou ORC.

Chargement par flux (streaming) : BigQuery offre une API de streaming qui permet de charger des données en temps réel. Cette méthode est idéale pour les applications nécessitant des données à jour en temps réel.

Chargement via Data Transfer Service : Ce service permet d’automatiser le chargement des données depuis diverses sources telles que Google Ads, YouTube, ou des bases de données externes.

Chargement via des requêtes SQL : Les données peuvent être chargées directement via des requêtes SQL en utilisant des instructions INSERT ou des requêtes CREATE TABLE AS SELECT (CTAS).

Quels sont les exemples de code SQL pour le chargement ?

Pour illustrer les capacités de chargement de BigQuery, voici quelques exemples de code SQL couramment utilisés :

Chargement depuis des fichiers CSV :

sqlCopy code-- Chargement des données depuis un fichier CSV

LOAD DATA INFILE 'gs://my-bucket/my-file.csv'

INTO TABLE my_dataset.my_table

FIELDS TERMINATED BY ','

ENCLOSED BY '"'

LINES TERMINATED BY '\n'

IGNORE 1 LINES;Explication :

LOAD DATA INFILE 'gs://my-bucket/my-file.csv': Charge les données depuis le fichier CSV situé dans le bucket Google Cloud Storagemy-bucket.INTO TABLE my_dataset.my_table: Spécifie la table ciblemy_tabledans le datasetmy_dataset.FIELDS TERMINATED BY ',': Indique que les champs du CSV sont séparés par des virgules.ENCLOSED BY '"': Indique que les champs sont entourés de guillemets.LINES TERMINATED BY '\n': Indique que les lignes sont séparées par des retours à la ligne.IGNORE 1 LINES: Ignore la première ligne du fichier CSV, généralement l’en-tête.

Chargement par flux (streaming) :

sqlCopy code-- Exemple de chargement par flux

INSERT INTO my_dataset.my_table (column1, column2, column3)

VALUES ('value1', 'value2', 'value3');Explication :

INSERT INTO my_dataset.my_table (column1, column2, column3): Insère des données dans les colonnes spécifiées de la tablemy_tabledans le datasetmy_dataset.VALUES ('value1', 'value2', 'value3'): Spécifie les valeurs à insérer dans les colonnescolumn1,column2etcolumn3.

Chargement via des requêtes SQL (CTAS) :

sqlCopy code-- Création et chargement d'une nouvelle table à partir d'une requête SQL

CREATE TABLE my_dataset.new_table AS

SELECT *

FROM my_dataset.existing_table

WHERE condition_column = 'condition_value';Explication :

CREATE TABLE my_dataset.new_table AS: Crée une nouvelle tablenew_tabledans le datasetmy_datasetet y insère les données issues de la requête suivante.SELECT * FROM my_dataset.existing_table: Sélectionne toutes les colonnes de la tableexisting_tablesituée dans le datasetmy_dataset.WHERE condition_column = 'condition_value': Filtre les lignes de la table source où la colonnecondition_columna la valeurcondition_value. Seules ces lignes seront insérées dans la nouvelle tablenew_table.

Chargement depuis Google Cloud Storage :

sqlCopy code-- Chargement des données depuis Google Cloud Storage

bq load --source_format=CSV my_dataset.my_table gs://my-bucket/my-file.csvExplication :

bq load --source_format=CSV: Utilise l’outil de ligne de commandebqpour charger des données dans BigQuery au format CSV.my_dataset.my_table: Spécifie la table ciblemy_tabledans le datasetmy_dataset.gs://my-bucket/my-file.csv: Indique le chemin du fichier CSV dans Google Cloud Storage.

Ces exemples montrent comment BigQuery peut être utilisé pour charger des données de différentes manières, en fonction des besoins spécifiques de votre application. En choisissant la bonne méthode et en appliquant des pratiques optimales, vous pouvez assurer un chargement efficace et fiable de vos données dans BigQuery.

Quels sont les outils et technologies ETL disponibles ?

Dans le domaine de la gestion des données, le processus ETL (Extraction, Transformation et Chargement) joue un rôle crucial en permettant de transférer et de transformer les données entre différentes sources et destinations. Divers outils et technologies ont été développés pour faciliter ce processus, chacun offrant des fonctionnalités spécifiques adaptées à des besoins variés. Ce chapitre explore les outils ETL traditionnels, les outils No Code, l’intégration de BigQuery avec d’autres outils, et fournit une comparaison détaillée des principaux outils ETL disponibles sur le marché.

Quels sont les outils ETL traditionnels ?

Les outils ETL traditionnels sont des solutions éprouvées qui ont été largement adoptées par les entreprises pour gérer leurs processus ETL. Voici quelques-uns des outils les plus populaires :

Informatica PowerCenter : C’est l’un des outils ETL les plus anciens et les plus robustes, largement utilisé dans de nombreuses industries. Il offre une interface utilisateur graphique pour concevoir, exécuter et surveiller des workflows ETL complexes. Informatica PowerCenter est connu pour sa capacité à gérer de grandes quantités de données et à s’intégrer avec une variété de sources de données.

IBM InfoSphere DataStage : Cet outil ETL fait partie de la suite IBM InfoSphere et est utilisé pour extraire, transformer et charger des données à partir de différentes sources. DataStage offre des fonctionnalités avancées pour la gestion des données volumineuses et des capacités de parallélisme pour améliorer les performances des processus ETL.

Microsoft SQL Server Integration Services (SSIS) : SSIS est une plateforme de solutions ETL développée par Microsoft. Elle est intégrée à SQL Server et offre une large gamme de composants pour l’extraction, la transformation et le chargement des données. SSIS est particulièrement apprécié pour son intégration étroite avec d’autres produits Microsoft et sa facilité d’utilisation pour les utilisateurs de SQL Server.

Talend Open Studio : Talend est une solution ETL open-source qui offre une grande flexibilité et une vaste bibliothèque de connecteurs pour diverses sources de données. Talend Open Studio permet aux utilisateurs de créer des workflows ETL en utilisant une interface graphique intuitive et offre des fonctionnalités avancées pour la gestion des données et l’intégration des applications.

Apache Nifi : Nifi est un projet open-source de la fondation Apache qui permet l’automatisation des flux de données entre différents systèmes. Il offre une interface utilisateur pour concevoir des flux de données complexes et une architecture distribuée pour gérer les grandes quantités de données en temps réel. Nifi est particulièrement utile pour les environnements nécessitant une intégration de données en continu.

Quels sont les outils ETL No Code ?

Les outils No Code sont de plus en plus populaires pour les processus ETL, car ils permettent aux utilisateurs de créer des workflows complexes sans écrire de code. Ces outils sont particulièrement utiles pour les entreprises qui cherchent à accélérer leur développement et à réduire les coûts de main-d’œuvre. Nous proposons des formations Make pour apprendre à automatiser le traitements ETL de vos données. Voici quelques exemples d’outils ETL No Code :

Make (anciennement Integromat) : Make est un outil No Code qui permet d’automatiser les workflows en connectant diverses applications et services. Avec une interface visuelle intuitive, les utilisateurs peuvent créer des scénarios d’automatisation pour extraire, transformer et charger des données sans écrire une seule ligne de code. Make offre une large bibliothèque de connecteurs pour des applications populaires comme Google Sheets, Slack, et bien sûr, BigQuery.

n8n : n8n est une plateforme d’automatisation open-source qui permet de créer des workflows ETL sans code. Elle offre une interface graphique où les utilisateurs peuvent connecter différents nœuds pour créer des flux de données automatisés. n8n est très flexible et peut être auto-hébergé, offrant ainsi une grande liberté et contrôle sur les processus ETL. Il dispose également d’un grand nombre de connecteurs pour diverses applications et services.

Zapier : Zapier est un autre outil No Code très populaire pour l’automatisation des workflows. Il permet de connecter plus de 2000 applications et services pour automatiser les tâches récurrentes. Les utilisateurs peuvent créer des « Zaps » qui automatisent l’extraction, la transformation et le chargement des données entre différentes applications, y compris BigQuery.

Comment intégrer BigQuery avec d’autres outils ?

L’intégration de BigQuery avec d’autres outils ETL permet d’étendre ses capacités et de simplifier la gestion des processus ETL. Voici quelques méthodes pour intégrer BigQuery avec différents outils :

Utilisation de connecteurs natifs : De nombreux outils ETL offrent des connecteurs natifs pour BigQuery. Ces connecteurs permettent de se connecter facilement à BigQuery, d’extraire des données, de les transformer et de les charger dans BigQuery. Par exemple, Talend, Informatica et SSIS disposent tous de connecteurs natifs pour BigQuery.

API et SDK : BigQuery propose des API RESTful et des SDK pour plusieurs langages de programmation, notamment Python, Java et Go. Ces API et SDK permettent de développer des solutions personnalisées pour intégrer BigQuery avec d’autres outils et plateformes. Les développeurs peuvent utiliser ces interfaces pour automatiser les processus ETL et intégrer BigQuery dans leurs workflows existants.

BigQuery Data Transfer Service : Ce service géré par Google permet de transférer automatiquement des données de diverses sources vers BigQuery. Il prend en charge des sources de données telles que Google Ads, YouTube, Google Cloud Storage, et bien d’autres. Le Data Transfer Service simplifie le processus d’intégration en offrant une solution clé en main pour importer des données dans BigQuery.

Utilisation de services de cloud computing : Les plateformes de cloud computing comme Google Cloud Platform (GCP), AWS et Azure offrent des services ETL intégrés qui peuvent être utilisés en conjonction avec BigQuery. Par exemple, Google Cloud Dataflow peut être utilisé pour créer des pipelines de données qui intègrent BigQuery, tandis qu’AWS Glue et Azure Data Factory offrent des fonctionnalités similaires pour leurs écosystèmes respectifs.

Comment comparer les outils ETL ?

Lors de la sélection d’un outil ETL, il est essentiel de comparer les différentes options disponibles en fonction de divers critères. Voici quelques aspects à considérer lors de la comparaison des outils ETL :

Fonctionnalités : Comparez les fonctionnalités offertes par chaque outil, telles que la prise en charge des sources de données, les capacités de transformation, les options de chargement et les fonctionnalités de surveillance. Assurez-vous que l’outil choisi répond à vos besoins spécifiques en matière de gestion des données.

Facilité d’utilisation : Évaluez l’interface utilisateur et la courbe d’apprentissage de chaque outil. Certains outils offrent des interfaces graphiques intuitives qui simplifient la conception des workflows ETL, tandis que d’autres nécessitent des compétences en programmation plus avancées.

Performances : Considérez les capacités de traitement des données de chaque outil, en particulier pour les grandes quantités de données. Les outils ETL doivent être capables de gérer efficacement les charges de travail importantes sans compromettre les performances.

Coût : Comparez les coûts associés à chaque outil, y compris les licences, les coûts d’infrastructure et les coûts de maintenance. Les solutions open-source peuvent offrir des économies substantielles, mais elles peuvent également nécessiter plus de ressources pour l’implémentation et le support.

Évolutivité : Assurez-vous que l’outil ETL choisi peut évoluer avec vos besoins croissants en matière de données. Les solutions basées sur le cloud, par exemple, offrent souvent des options d’évolutivité flexibles pour répondre aux augmentations de volume de données et de complexité des processus ETL.

Support et communauté : Évaluez le support technique et la communauté utilisateur de chaque outil. Un bon support technique peut être crucial pour résoudre les problèmes rapidement, tandis qu’une communauté active peut fournir des ressources supplémentaires telles que des tutoriels, des forums et des extensions.

En comparant ces critères, vous pouvez sélectionner l’outil ETL le mieux adapté à vos besoins spécifiques et assurer la réussite de vos projets de gestion des données.

Les outils et technologies ETL jouent un rôle vital dans la gestion des données en entreprise, permettant de transférer, transformer et charger les données de manière efficace et fiable. En comprenant les différentes options disponibles et en choisissant les outils adaptés à vos besoins spécifiques, vous pouvez optimiser vos processus ETL et tirer le meilleur parti de vos données. BigQuery, avec ses capacités puissantes et ses intégrations flexibles, est une solution de choix pour de nombreuses organisations cherchant à améliorer leur gestion des données. Les outils No Code comme Make et n8n offrent également des solutions accessibles et puissantes pour automatiser les workflows ETL sans nécessiter de compétences en programmation, ce qui permet d’élargir l’accès à des processus ETL efficaces à un plus grand nombre d’utilisateurs.

En conclusion

La conclusion d’un guide complet sur le processus ETL (Extraction, Transformation et Chargement) avec BigQuery est l’occasion de récapituler les points essentiels, de réfléchir à l’impact et aux bénéfices des pratiques ETL optimisées, et d’explorer les perspectives d’avenir pour les processus ETL dans le contexte de BigQuery et des technologies émergentes. Ce chapitre se concentre sur les points clés à retenir, les tendances futures de l’ETL avec BigQuery, et propose des ressources supplémentaires pour approfondir vos connaissances et compétences en ETL.

Quels sont les points clés à retenir ?

Au cours de ce guide, nous avons exploré en détail les différentes phases du processus ETL et comment BigQuery peut être utilisé pour optimiser chaque étape. Voici les points clés à retenir :

Compréhension du processus ETL avec BigQuery : Le processus ETL est crucial pour préparer les données en vue d’analyses et de prises de décisions. BigQuery offre des capacités puissantes pour gérer efficacement l’extraction, la transformation et le chargement des données.

Extraction des données : Cette première étape consiste à récupérer des données de diverses sources. Utiliser des méthodes d’extraction adaptées et optimiser les requêtes d’extraction est essentiel pour garantir que les données sont récupérées efficacement.

Transformation des données : La transformation est l’étape où les données brutes sont nettoyées, normalisées et enrichies. BigQuery propose des outils et des fonctions avancées pour effectuer des transformations complexes, optimisant ainsi la qualité et l’utilisabilité des données.

Chargement des données : Le chargement consiste à importer les données transformées dans BigQuery. Choisir la bonne stratégie de chargement (complet, incrémentiel, par lots ou en temps réel) et optimiser les performances de chargement sont cruciaux pour garantir des opérations fluides et efficaces.

Outils et technologies ETL : De nombreux outils ETL traditionnels et No Code, comme Informatica, Talend, Make et n8n, peuvent être intégrés à BigQuery pour faciliter et automatiser les processus ETL. Choisir le bon outil dépend des besoins spécifiques de votre organisation.

Bonnes pratiques ETL avec BigQuery : Suivre les bonnes pratiques, telles que l’optimisation des performances, la gestion des erreurs et des exceptions, la sécurité des données et la surveillance continue, est essentiel pour garantir des processus ETL robustes et efficaces.

Quel est le futur de l’ETL avec BigQuery ?

Les processus ETL évoluent rapidement avec l’émergence de nouvelles technologies et paradigmes de gestion des données. Voici quelques tendances futures à surveiller :

Intégration des technologies de streaming de données : Avec l’augmentation des besoins en temps réel, les technologies de streaming comme Apache Kafka et Google Cloud Dataflow deviennent de plus en plus importantes. L’intégration de ces technologies avec BigQuery permet de traiter et d’analyser les données en temps réel, offrant des insights plus immédiats.

Adoption croissante du No Code et de l’IA : Les outils No Code et les solutions basées sur l’intelligence artificielle simplifient les processus ETL et les rendent accessibles à un plus grand nombre d’utilisateurs. Les outils comme Make, n8n et les plateformes d’IA automatisée vont continuer à se développer, réduisant la dépendance aux développeurs et permettant des itérations plus rapides.

Évolution vers le DataOps : Le DataOps, une approche qui applique les principes de DevOps à la gestion des données, est en train de transformer la manière dont les équipes gèrent les processus ETL. En intégrant les pratiques de CI/CD (Intégration Continue et Déploiement Continu), le DataOps permet des pipelines de données plus agiles et résilients.

Avancées en matière de sécurité et de conformité : Avec des réglementations de plus en plus strictes sur la protection des données, les outils ETL et les plateformes comme BigQuery continueront d’évoluer pour offrir des fonctionnalités avancées de sécurité et de conformité. L’accent sera mis sur le chiffrement, la gestion des accès et l’audit des données pour garantir la confidentialité et l’intégrité des informations.

Expansions des capacités de BigQuery : Google Cloud continue d’innover et d’améliorer BigQuery, ajoutant de nouvelles fonctionnalités et améliorant les performances. Les futures mises à jour pourraient inclure des optimisations supplémentaires pour les requêtes, de nouvelles intégrations de services et des améliorations des capacités de machine learning.

Quelles sont les ressources supplémentaires et lectures recommandées ?

Pour approfondir vos connaissances sur les processus ETL et l’utilisation de BigQuery, voici quelques ressources et lectures recommandées :

Documentation officielle de BigQuery : La documentation officielle de BigQuery offre une mine d’informations sur les fonctionnalités, les meilleures pratiques et les guides d’utilisation.

Cours en ligne et certifications : Des plateformes comme Coursera, Udemy et LinkedIn Learning proposent des cours spécialisés sur BigQuery, l’ETL et les outils de data warehousing. Des certifications telles que la Google Cloud Professional Data Engineer peuvent également renforcer vos compétences et votre crédibilité professionnelle.

Blogs et articles techniques : Suivre les blogs et les articles techniques de Google Cloud et d’autres experts en données peut fournir des insights précieux et des mises à jour sur les dernières tendances et pratiques. Des sites comme Medium, Towards Data Science et les blogs d’entreprises de données sont de bonnes sources d’information.

Communautés et forums : Participer à des communautés en ligne et des forums, comme Stack Overflow, Reddit, et les groupes LinkedIn, peut offrir des opportunités de partage de connaissances et de résolution de problèmes avec d’autres professionnels du domaine.

Livres sur l’ETL et le data warehousing : Il existe de nombreux livres qui approfondissent les concepts de l’ETL et du data warehousing. Quelques recommandations incluent « The Data Warehouse Toolkit » de Ralph Kimball et « ETL Data Integration » de Mark Scarr.

En récapitulant les points clés, en explorant les tendances futures et en fournissant des ressources supplémentaires, ce chapitre conclut notre guide complet sur le processus ETL avec BigQuery. En appliquant les bonnes pratiques et en tirant parti des outils et technologies disponibles, vous pouvez optimiser vos processus ETL et maximiser la valeur de vos données. BigQuery, avec ses capacités robustes et ses intégrations flexibles, est une plateforme puissante pour les entreprises cherchant à améliorer leur gestion des données et à obtenir des insights précieux. Continuer à apprendre et à s’adapter aux évolutions du domaine est essentiel pour rester compétitif et efficace dans la gestion des données.

FAQ sur les processus ETL avec BigQuery

Qu’est-ce qu’un ETL et pourquoi est-il important ?

ETL est un acronyme pour Extraction, Transformation et Chargement. C’est un processus utilisé pour collecter des données à partir de diverses sources, les transformer en un format approprié pour l’analyse et les charger dans un entrepôt de données. Ce processus est crucial pour assurer que les données sont propres, cohérentes et prêtes à être analysées pour des prises de décisions éclairées.

Pourquoi utiliser BigQuery pour les processus ETL ?

BigQuery est une solution de data warehousing gérée par Google Cloud qui offre des performances élevées, une évolutivité massive et une simplicité d’utilisation. BigQuery est idéal pour les processus ETL car il permet de traiter de grandes quantités de données rapidement, offre des fonctionnalités avancées pour la transformation des données et s’intègre facilement avec divers outils ETL et autres services Google Cloud.

Comment BigQuery optimise-t-il les performances des processus ETL ?

BigQuery optimise les performances des processus ETL grâce à plusieurs fonctionnalités clés :

- Partitionnement et clustering des tables pour réduire le volume de données scanné par les requêtes.

- Tables matérialisées pour stocker les résultats de requêtes complexes et améliorer les temps de réponse.

- Fonctions analytiques avancées et optimisation automatique des requêtes pour traiter les données efficacement.

Quels sont les principaux outils ETL qui s’intègrent avec BigQuery ?

De nombreux outils ETL s’intègrent bien avec BigQuery, notamment :

- Informatica PowerCenter

- IBM InfoSphere DataStage

- Microsoft SQL Server Integration Services (SSIS)

- Talend Open Studio

- Apache Nifi

- Outils No Code comme Make et n8n

Quelles sont les bonnes pratiques pour gérer les erreurs et les exceptions dans BigQuery ?

Pour gérer les erreurs et les exceptions dans BigQuery :

- Validez les données avant le chargement pour assurer leur qualité.

- Utilisez des clauses de gestion des erreurs dans les requêtes SQL, comme

IFNULL,COALESCEetTRY_CAST. - Mettez en place des systèmes de surveillance et d’alertes pour détecter les anomalies en temps réel.

- Développez des stratégies de reprise pour gérer les échecs et reprendre les processus ETL à partir du point d’échec.

Comment assurer la sécurité et la conformité des données dans BigQuery ?

Pour garantir la sécurité et la conformité des données dans BigQuery :

- Utilisez le contrôle d’accès basé sur les rôles (RBAC) pour gérer les permissions des utilisateurs.

- Appliquez des clés de chiffrement gérées par le client (CMEK) pour un contrôle supplémentaire sur le chiffrement des données.

- Mettez en place des mécanismes d’audit et de surveillance pour suivre les accès et les modifications des données.

- Respectez les réglementations en vigueur, telles que le RGPD et le CCPA, en mettant en œuvre des politiques de gestion des données strictes.

Quelles sont les options de chargement des données dans BigQuery ?

BigQuery offre plusieurs options pour charger des données :

- Chargement depuis des fichiers (CSV, JSON, Avro, Parquet, ORC) stockés dans Google Cloud Storage.

- Chargement par flux (streaming) pour les données en temps réel.

- BigQuery Data Transfer Service pour automatiser le transfert de données depuis diverses sources.

- Requêtes SQL utilisant des instructions

INSERTouCREATE TABLE AS SELECT (CTAS).

Comment surveiller et maintenir les processus ETL dans BigQuery ?

Pour surveiller et maintenir les processus ETL dans BigQuery :

- Utilisez les outils de surveillance de BigQuery pour suivre les performances des requêtes et identifier les goulots d’étranglement.

- Automatisez les tâches de maintenance courantes avec des scripts et des outils d’automatisation.

- Documentez vos processus ETL et suivez les modifications apportées aux workflows et scripts.

- Fournissez une formation continue et un support à votre équipe pour maintenir leurs compétences à jour.

Quels sont les avantages des outils ETL No Code comme Make et n8n ?

Les outils ETL No Code comme Make et n8n offrent plusieurs avantages :

- Facilité d’utilisation : Permettent aux utilisateurs de créer des workflows ETL sans écrire de code.

- Rapidité de déploiement : Accélèrent le développement et la mise en œuvre des processus ETL.

- Flexibilité : Offrent une large gamme de connecteurs pour diverses applications et services.

- Accessibilité : Rendent les processus ETL accessibles à un plus grand nombre d’utilisateurs, y compris ceux sans compétences en programmation.

Quelles sont les tendances futures pour les processus ETL avec BigQuery ?

Les tendances futures pour les processus ETL avec BigQuery incluent :

- Intégration des technologies de streaming de données pour traiter les données en temps réel.

- Adoption croissante du No Code et de l’IA pour simplifier les processus ETL.

- Évolution vers le DataOps pour des pipelines de données plus agiles et résilients.

- Avancées en matière de sécurité et de conformité pour protéger les données sensibles.

- Expansions des capacités de BigQuery avec de nouvelles fonctionnalités et améliorations des performances.

Quelles ressources supplémentaires sont disponibles pour en savoir plus sur BigQuery et l’ETL ?

Pour approfondir vos connaissances sur BigQuery et l’ETL :

- Consultez la documentation officielle de BigQuery.

- Suivez des cours en ligne et certifications sur des plateformes comme Coursera, Udemy et LinkedIn Learning.

- Lisez des blogs et articles techniques de Google Cloud et d’autres experts en données.

- Participez à des communautés et forums en ligne comme Stack Overflow et Reddit.

- Lisez des livres spécialisés tels que « The Data Warehouse Toolkit » de Ralph Kimball et « ETL Data Integration » de Mark Scarr.